Was sind die Kennzeichen eines psychologischen Tests?

Definition eines (psychologischen) Tests (Moosbrugger & Kelava, 2008, S. 2):

Ein Test ist ein wissenschaftliches Routineverfahren zur Erfassung eines oder mehrerer empirisch abgrenzbarer psychologischer Merkmale mit dem Ziel einer möglichst genauen quantitativen Aussage über den Grad der individuellen Merkmalsausprägung.

Ein Test ist ein wissenschaftliches Routineverfahren zur Erfassung eines oder mehrerer empirisch abgrenzbarer psychologischer Merkmale mit dem Ziel einer möglichst genauen quantitativen Aussage über den Grad der individuellen Merkmalsausprägung.

- Muss wissenschaftlich sein

- Soll ein Routineverfahren sein

- Soll psychologische Merkmale messen

- Soll eine quantitative Aussage machen (soll eine Messung liefern)

Tags: Definition, Merkmal, Routineverfahren, Test, Wissenschaft

Quelle: F3

Quelle: F3

Was kennzeichnet Wissenschaftlichkeit bzw. wann kann man von wissenschaftlich sprechen?

Was sind die primären Aufgabengebiete der Testtheorie?

Was sind die primären Aufgabengebiete der Testtheorie?

Um von wissenschaftlich sprechen zu können, muss es eine Theorie darüber geben, unter welchen Bedingungen welche Aussagen anhand der Testergebnisse ableitbar sind.

Demnach sollte eine möglichst genaue Vorstellung über das zu messende Merkmal vorliegen und der Test testtheoretischen Qualitätsansprüchen entsprechen.

Die (primären) Aufgabengebiete der Testtheorie sind

Demnach sollte eine möglichst genaue Vorstellung über das zu messende Merkmal vorliegen und der Test testtheoretischen Qualitätsansprüchen entsprechen.

Die (primären) Aufgabengebiete der Testtheorie sind

- die Formulierung des theoretischen Hintergrunds über die Verbindung von zu messendem Merkmal und im Test gezeigtem Verhalten sowie

- die Festlegung und Quantifizierung notweniger Qualitätsansprüche.

Tags: Definition, Testtheorie, Wissenschaft

Quelle: F4

Quelle: F4

Wann spricht man von einem Routineverfahren?

Von einem Routineverfahren spricht man, wenn Durchführung und Auswertung

(Wird häufiger angewandt: es gibt Erfahrungswerte und ist an größeren Stichproben erprobt und Wissen über Durchführung und Auswertung soll vorhanden sein)

- bereits an einer größeren Stichprobe erprobt sind und

- so detailliert beschrieben sind, dass das Verfahren auch von anderen „TestleiterInnen“ bei anderen Personen einsetzbar ist.

(Wird häufiger angewandt: es gibt Erfahrungswerte und ist an größeren Stichproben erprobt und Wissen über Durchführung und Auswertung soll vorhanden sein)

Tags: Definition, Routineverfahren, Tests

Quelle: F5

Quelle: F5

Was versteht man unter einem psychologischen Merkmal?

Bei einem psychologischen Merkmal handelt es sich um einen Oberbegriff für

Diese meist nicht direkt beobachtbaren (=latenten) Merkmale sollen mit Hilfe von messbaren Sachverhalten „erschlossen“ werden.

(Es werden Items gemessen und auf Merkmale geschlossen)

- relativ stabile und konsistente Merkmale (auch „Eigenschaften“ oder „Traits“ genannt),

- zeitlich begrenzte biologische, emotionale und kognitive Zustände sowie (auch „States“ genannt) und

- Erlebens- und Verhaltensweisen.

Diese meist nicht direkt beobachtbaren (=latenten) Merkmale sollen mit Hilfe von messbaren Sachverhalten „erschlossen“ werden.

(Es werden Items gemessen und auf Merkmale geschlossen)

Tags: Definition, Merkmal

Quelle: F6

Quelle: F6

Was versteht man darunter das Tests quantitative Aussagen machen sollen?

Ziel psychologischer Tests ist es die Ausprägung des Merkmals der gestestete Person zu messen.

Messen bedeutet einem Objekt (empirisches Relativ) einen Zahlenwert (numerisches Relativ) so zuzuordnen, dass zumindest eine Eigenschaft des numerischen Relativs auch für das empirische Relativ gilt.

(vgl. Bortz J. (1999) Statistik für Sozialwissenschaftler, 5. Auflage S. 18 - 20).

Dieser Zahlenwert kann in weiterer Folge dazu verwendet werden, die Person mit anderen Personen vergleichen oder einer Personengruppe zuordnen zu können.

Je nach theoretischer Fundierung des Messvorgangs haben die erzielten Zahlenwerte unterschiedliches Skalenniveau.

Messen bedeutet einem Objekt (empirisches Relativ) einen Zahlenwert (numerisches Relativ) so zuzuordnen, dass zumindest eine Eigenschaft des numerischen Relativs auch für das empirische Relativ gilt.

(vgl. Bortz J. (1999) Statistik für Sozialwissenschaftler, 5. Auflage S. 18 - 20).

Dieser Zahlenwert kann in weiterer Folge dazu verwendet werden, die Person mit anderen Personen vergleichen oder einer Personengruppe zuordnen zu können.

Je nach theoretischer Fundierung des Messvorgangs haben die erzielten Zahlenwerte unterschiedliches Skalenniveau.

Tags: Definition, Messung, Skalenniveau, Test

Quelle: F8

Quelle: F8

Was versteht man unter einem Fragebogen?

Der Begriff wird im Deutschen für Unterschiedliches verwendet.

Gemeinsam ist beiden, dass das „Erfragen“ im Vordergrund steht.

- schriftliche Befragungen zur Erhebung von - demoskopischen Daten- schulischen Daten- medizinischen Daten- usw.

- Instrument zur „Selbst- oder Fremdeinschätzung“ - wird meist zur Erfassung von Persönlichkeitseigenschaften und Interessen verwendet- Häufig auch als Persönlichkeits“test“ bezeichnet

Gemeinsam ist beiden, dass das „Erfragen“ im Vordergrund steht.

Tags: Definition, Fragebogen

Quelle: F11

Quelle: F11

Welche Testarten können unterschieden werden?

Je nach Merkmal, das erfasst werden soll, werden drei/vier unterschiedliche Testarten unterschieden

* Die Bezeichnung „Persönlichkeitsfragebogen“ unterscheidet sich bewusst von der im Buch von Moosbrugger & Kelava (2008), S.29 gewählten, da die Personen hier „befragt“ werden.

- Leistungstests

- Persönlichkeits- und Interessensfragebögen*

- [objektive Persönlichkeitstests]

- projektive Verfahren

- apperative Tests

* Die Bezeichnung „Persönlichkeitsfragebogen“ unterscheidet sich bewusst von der im Buch von Moosbrugger & Kelava (2008), S.29 gewählten, da die Personen hier „befragt“ werden.

Tags: Definition, Test, Testarten

Quelle: F12

Quelle: F12

Wodurch sind Leistungstests gekennzeichnet? Beispiele?

Sind dadurch gekennzeichnet, dass sie

- Konstrukte erfassen, die sich auf kognitive Leistungen beziehen

- die unter der jeweiligen Testbedingung maximale Leistung erfassen möchten

- Aufgaben verwenden, bei denen es „richtige“ und „falsche“ Antworten gibt

Tags: Definition, Leistungstest, Test

Quelle: F13

Quelle: F13

Wodurch sind Persönlichkeitsfragebögen gekennzeichnet? Beispiel?

Sind dadurch gekennzeichnet, dass sie

- das Ziel verfolgen, das für eine Person typische Verhalten zu erfassen,

- mehrere Fragen verwenden, um das Persönlichkeitsmerkmal zu erfassen,

- die Antworten nicht in „richtig“ und „falsch“ klassifizierbar sind, sondern „erfragen“, wie stark das interessierende Merkmal ausgeprägt ist und

- im Allgemeinen leicht verfälschbar sind (z.B. durch sozial erwünschte Antworten).

Tags: Definition, Fragebogen, Persönlichkeitsfragebogen, Test

Quelle: F17

Quelle: F17

Was kennzeichnet objektive Persönlichkeitstests?

Sind dadurch gekennzeichnet, dass sie

(„Tarnen“ sich als Leistungstests, sind aber Persönlichkeitstests)

- versuchen, das Ausmaß an „Verfälschbarkeit“ z.B. durch „sozial erwünschte Antworten“ zu reduzieren indem sie

- das Persönlichkeitsmerkmal nicht durch subjektive Urteile, sondern über Verhalten in standardisierten Situationen erfassen.

(„Tarnen“ sich als Leistungstests, sind aber Persönlichkeitstests)

Tags: Definition, Objektiver Persönlichkeitstest, Persönlichkeitstest, Test

Quelle: F19

Quelle: F19

Was kennzeichnet projektive Tests?

Sind dadurch gekennzeichnet, dass sie

- versuchen, die Persönlichkeit als Ganzes zu erfassen, wobei sie

- auf individuelle Erlebnis- und Bedürfnisstrukturen Rücksicht nehmen,

- mehrdeutiges Bildmaterial verwenden, um unbewusste oder verdrängte Bewusstseinsinhalte zu erfassen und

- oft explorativen Charakter haben. (Man erhält keine konkrete Zahl)

Tags: Definition, projektiver Test, Test

Quelle: F20

Quelle: F20

Welche 2 Arten von apparative Tests werden unterschieden?

Moosbrugger & Kelava (2008), S. 32 unterscheiden im Wesentlichen zwei Arten

- Tests, sie insbesondere sensorische und motorische Merkmale erfassen. z.B.Tests zur - Erfassung von Muskelkraft- Geschicklichkeit- sensumotorischer Koordination

- computerbasierte Tests, die häufig spezielle Varianten von Leistungstests und Persönlichkeitsfragebogen sind.

Tags: apparativer Test, Definition, Test

Quelle: F24

Quelle: F24

Welche Testgütekritieren können unterschieden werden (im Überblick)?

Hauptgütekriterien

Nebengütekriterien

- Objektivität

- Reliabilität

- Validität

Nebengütekriterien

- Skalierung

- Normierung

- Ökonomie

- Nützlichkeit

- Zumutbarkeit

- Unverfälschbarkeit

- Fairness

Tags: Objektivität, Reliabilität, Testgütekriterien, Validität

Quelle: F26

Quelle: F26

Was versteht man unter Objektivität und welche 3 Bereiche lassen sich unterscheiden?

Ein Test ist objektiv, wenn er dasjenige Merkmal, das er misst, unabhängig von TestleiterIn, TestauswerterIn und von der Ergebnisinterpretation misst.

(angelehnt an Moosbrugger & Kelava, 2008, S. 8)

Bei der Objektivität lassen sich drei Bereiche unterscheiden

(angelehnt an Moosbrugger & Kelava, 2008, S. 8)

Bei der Objektivität lassen sich drei Bereiche unterscheiden

- Durchführungsobjektivität (~Testleiterunabhängigkeit*)

- Auswertungsobjektivität (~Verrechnungssicherheit*)

- Interpretationsobjektivität (~Interpretationseindeutigkeit*)

Tags: Definition, Objektivität

Quelle: F27

Quelle: F27

Was versteht man unter Durchführungsobjektivität?

Durchführungsobjektivität ist gegeben, wenn das Ergebnis der Testung nicht davon abhängt, welche TestleiterIn, die Testung durchgeführt.

Demnach sollte die Testvorgabe unter möglichst standardisierten Bedingungen stattfinden.

Diese werden optimiert indem

Demnach sollte die Testvorgabe unter möglichst standardisierten Bedingungen stattfinden.

Diese werden optimiert indem

- Instruktionen, die die TestleiterInnen geben, schriftlich festgehalten sind,

- die soziale Interaktion zwischen TestleiterIn und getesteter Person möglichst gering gehalten wird und

- die Untersuchungssituationen möglichst ähnlich sind.

Tags: Definition, Objektivität

Quelle: F29

Quelle: F29

Was versteht man unter Auswertungsobjektivität?

Ist gegeben, wenn beim Vorliegen der Antworten der Personen auf die Fragen (=Testprotokoll) jede(r) AuswerterIn zum selben numerischen Testergebnis kommt.

Die Auswertungsobjektivität kann erhöht/gesichert werden durch

Die Auswertungsobjektivität kann durch statistische Kennzahlen zur Beurteilerübereinstimmung (z.B. Cohens Kappa, Fleiss Kappa, Konkordanzkoeffizienten nach Kendall) erfasst werden.

Die Auswertungsobjektivität kann erhöht/gesichert werden durch

- das Vermeiden freier Antwortformate,

- klare Auswertungsregeln und

- die Verwendung von Multiple-Choice (Mehrfachauswahl) Antworten.

Die Auswertungsobjektivität kann durch statistische Kennzahlen zur Beurteilerübereinstimmung (z.B. Cohens Kappa, Fleiss Kappa, Konkordanzkoeffizienten nach Kendall) erfasst werden.

Tags: Definition, Objektivität

Quelle: F30

Quelle: F30

Was versteht man unter Interpretationsobjektivität?

Ist gegeben, wenn beim Vorliegen der Testergebnisse unterschiedliche „TestanwenderInnen“ zum selben „Schluss“ kommen.

Die Interpretationsobjektivität kann erhöht/gesichert werden

durch

* Ein Prozentrang (PR) gibt an wie viel Prozent der „Referenzpopulation“ diesen oder einen schlechteren Testwert erzielen.

Die Interpretationsobjektivität kann erhöht/gesichert werden

durch

- klare Regeln für die Interpretation,

- Vorhandensein von Normen und Normwerten

- der Verwendung von Prozenträngen*.

* Ein Prozentrang (PR) gibt an wie viel Prozent der „Referenzpopulation“ diesen oder einen schlechteren Testwert erzielen.

Tags: Definition, Objektivität

Quelle: F31

Quelle: F31

Was versteht man unter Reliabilität und welche Arten lassen sich unterscheiden?

Ein Test ist dann (vollständig) reliabel, wenn er das Merkmal, das er misst, exakt, d.h. ohne Messfehler, misst.

(angelehnt an Moosbrugger & Kelava, 2008, S. 11)

Die Reliabilität eines Tests gibt den Grad der Genauigkeit an, mit dem ein Test ein bestimmtes Merkmal misst.

Allerdings geht es nicht darum, ob der Test auch jenes Merkmal misst, das er zu messen vorgibt.

Es lassen sich drei/vier Arten der Reliabilität unterscheiden

Näheres zur Reliabilität im Rahmen der Lehrveranstaltungseinheiten zur klassischen Testtheorie

(angelehnt an Moosbrugger & Kelava, 2008, S. 11)

Die Reliabilität eines Tests gibt den Grad der Genauigkeit an, mit dem ein Test ein bestimmtes Merkmal misst.

Allerdings geht es nicht darum, ob der Test auch jenes Merkmal misst, das er zu messen vorgibt.

Es lassen sich drei/vier Arten der Reliabilität unterscheiden

- Retest - Reliabilität

- Paralleltest - Reliabilität

- Innere Konsistenz

- [Testhalbierungs- (Split Half-) Reliabilität]

Näheres zur Reliabilität im Rahmen der Lehrveranstaltungseinheiten zur klassischen Testtheorie

Tags: Definition, Reliabilität

Quelle: F32

Quelle: F32

Was versteht man unter Validität und welche Arten können unterschieden werden?

Ein Test gilt dann als valide („gültig“), wenn er das Merkmal, das er messen soll, auch wirklich misst.

(angelehnt an Moosbrugger & Kelava, 2008, S. 13)

Die Validität ist im Hinblick auf die Praxis, das wichtigste Gütekriterium. Mit Hilfe der Validität lässt sich klären

Es lassen sich vier Arten der Validität unterscheiden

Näheres zur Validität im Rahmen der Lehrveranstaltungseinheiten zur klassischen Testtheorie und Faktorenanalyse.

(angelehnt an Moosbrugger & Kelava, 2008, S. 13)

Die Validität ist im Hinblick auf die Praxis, das wichtigste Gütekriterium. Mit Hilfe der Validität lässt sich klären

- wie sehr eine Test wirklich das zu messende Merkmal misst (~„Konstruktvalidität“) und

- wie gut der Testkennwert „Verhaltensweisen“ außerhalb der Testsituation vorhersagen kann (~„Kriteriumsvalidität“).

Es lassen sich vier Arten der Validität unterscheiden

- Inhaltsvalidität

- Augenscheinvalidität

- Konstruktvalidität

- Kriteriumsvalidität

Näheres zur Validität im Rahmen der Lehrveranstaltungseinheiten zur klassischen Testtheorie und Faktorenanalyse.

Tags: Definition, Validität

Quelle: F34

Quelle: F34

Was versteht man unter dem Gütekriterium der Skalierung?

Ein Test erfüllt das Gütekriterium Skalierung, wenn die laut Verrechnungsregel resultierenden Testwerte die empirische Merkmalsrelation adäquat abbilden.

(Moosbrugger & Kelava, 2008, S. 18)

Näheres zur Skalierung im Rahmen der Lehrveranstaltungseinheiten zur modernen Testtheorie.

(Moosbrugger & Kelava, 2008, S. 18)

Näheres zur Skalierung im Rahmen der Lehrveranstaltungseinheiten zur modernen Testtheorie.

Tags: Skalierung, Testgütekriterien

Quelle: F36

Quelle: F36

Was versteht man unter Normierung und wann ist das Gütekriterium erfüllt?

Unter Normierung (Eichung) eines Tests versteht man, das Erstellen eines Bezugssystems, mit dessen Hilfe die Ergebnisse einer Testperson im Vergleich zu den Merkmalsausprägungen anderer Personen eindeutig eingeordnet und interpretiert werden können.

(Moosbrugger & Kelava, 2008, S. 19)

Ziel der Normierung ist es einen Rahmen für die Interpretation der (durch eine Person) erzielten Testergebnisse zu schaffen. Dies erfolgt dadurch, dass die Testergebnisse in Normwerte umgewandelt werden.

Weit verbreitete Normwerte sind z.B.

Das Gütekriterium der Normierung (Eichung) kann als erfüllt angesehen werden, wenn

(Moosbrugger & Kelava, 2008, S. 19)

Ziel der Normierung ist es einen Rahmen für die Interpretation der (durch eine Person) erzielten Testergebnisse zu schaffen. Dies erfolgt dadurch, dass die Testergebnisse in Normwerte umgewandelt werden.

Weit verbreitete Normwerte sind z.B.

- Prozentränge,

- z-Werte,

- Z-Werte,

- IQ-Werte und

- T-Werte (nicht zu verwechseln mit den t-Werten des t-Tests).

Das Gütekriterium der Normierung (Eichung) kann als erfüllt angesehen werden, wenn

- die Eichtabellen gültig (d.h. nicht veraltet) sind,

- die Population für die Eichtabellen definiert ist und

- die für die Erstellung der Eichtabellen herangezogene Stichprobe repräsentativ ist*.

Tags: Normierung, Testgütekriterien

Quelle: F37

Quelle: F37

Was versteht man unter einem Prozentrang?

Der Prozentrang gibt an, wie viel Prozent der Normierungsstichprobe einen Testwert erzielen, der niedriger oder maximal ebenso hoch ist, wie der Testwert xv der Testperson v. Der Prozentrang entspricht somit dem prozentualen Flächenanteil der Häufigkeitsverteilung der Bezugsgruppe, der am unteren Skalenende beginnt und nach oben hin durch den Testwert xv begrenzt wird.

(nach Moosbrugger & Kelava, 2008, S. 168)

Prozentränge sind als Normwerte insofern besonders hervorzuheben, als sie

(nach Moosbrugger & Kelava, 2008, S. 168)

Prozentränge sind als Normwerte insofern besonders hervorzuheben, als sie

- keine Intervallskalierung der Testkennwerte voraussetzen,

- keine Normalverteilung der Testwerte voraussetzen und

- eine inhaltlich einfache Interpretation des Testergebnisses darstellen.

Tags: Prozentränge

Quelle: F40

Quelle: F40

Was versteht man unter z-Werte? Und wie sind die anderen Normwerte ableitbar?

z-Werte (Standardmesswerte)

Jedem z-Wert ist genau ein Prozentrang zugeordnet und umgekehrt. Diese Zuordnungen können anhand der aus der Statistik bekannten z-Tabellen abgelesen werden.

Mit Hilfe von z-Werten können intervallskalierte, aber nicht normalverteilte Testkennwerte in normalverteilte Testkennwerte transformiert werden (=Flächentransformation).

Aus den z-Werten sind alle üblicherweise verwendeten Normwerte ableitbar, mittels

Überblick

- sind im Falle intervallskalierter und normalverteilter Testkennwerte - definiert durch:

- legen die relative Position des Testkennwerts der getesteten Person bezogen auf die Referenzpopulation dar,

- sind positiv bei überdurchschnittlichen Leistungen,

- sind negativ bei unterdurchschnittlichen Testleistungen und

- Null bei durchschnittlichen Leistungen

Jedem z-Wert ist genau ein Prozentrang zugeordnet und umgekehrt. Diese Zuordnungen können anhand der aus der Statistik bekannten z-Tabellen abgelesen werden.

Mit Hilfe von z-Werten können intervallskalierte, aber nicht normalverteilte Testkennwerte in normalverteilte Testkennwerte transformiert werden (=Flächentransformation).

Aus den z-Werten sind alle üblicherweise verwendeten Normwerte ableitbar, mittels

Überblick

| Norm | Mittelwert M | Streuung s |

| z-Werte | 0 | 1 |

| IQ-Werte | 100 | 15 |

| Z-Werte (Standardwerte/SW) | 100 | 10 |

| T-Werte | 50 | 10 |

| C-Werte | 5 | 2 |

| Stanine-Werte | 5 | 2 |

| Sten-Werte | 5,5 | 2 |

| Wertpunkte | 10 | 3 |

| Prozentränge | (50%) | (34,1%) |

Tags: Normierung, Testgütekriterien, z-Wert

Quelle: F43

Quelle: F43

Berechne folgende Werte:

- z-Wert

- IQ-Wert

- Z-Wert

- T-Wert

Überblick

| Norm | Mittelwert M | Streuung s |

| z-Werte | 0 | 1 |

| IQ-Werte | 100 | 15 |

| Z-Werte (auch: Standardwerte oder SW) | 100 | 10 |

| T-Werte | 50 | 10 |

Tags: Normierung, z-Wert

Quelle: F48

Quelle: F48

In welche 6 Schritte lässt sich die Testkonstruktion unterteilen?

- Planung

- Itemkonstruktion

- Erstellung der vorläufigen Testversion

- Erprobung an Stichprobe

- Itemanalyse und Überarbeitung

- Normierung (Eichung)

Die Konstruktionsschritte können wiederum in mehrere Bereiche eingeteilt werden.

Tags: Testkonstruktion

Quelle: F50

Quelle: F50

Welche 4 unterschiedliche Strategien gibt es zu Itemkonstruktion? Beschreibe diese.

- intuitive Konstruktion

- rationale Konstruktion

- externale (kriteriumsorientierte) Konstruktion

- internale (faktorenanalytische) Konstruktion

Intuitive Konstruktion

Auf eine intuitive Konstruktion der Items sollte nur zurückgegriffen werden, wenn der theoretische Kenntnisstand bezüglich des interessierenden Merkmals gering ist (nach Moosbrugger & Kelava, 2008, S. 36).

Demnach ist die Konstruktion der Items abhängig von der Intuition der des/der TestkonstrukteurIn.

Rationale Konstruktion

Bei einer rationalen Konstruktion besteht bereits eine elaborierte Theorie über die Differenziertheit von Personen hinsichtlich des interessierenden Merkmals.

Es ist wesentlich

- das Merkmal zu differenzieren und spezifizieren sowie

- Verhaltensindikatoren festzulegen.

Externale (kriteriumsorientierte) Konstruktion

Hierbei wird zunächst ein großer Itempool zusammengestellt und Personen vorgegeben, die sich in dem interessierenden, externalen Merkmal (Kriterium) stark unterscheiden.

Im Anschluss werden jene Items ausgewählt, die gut zwischen Gruppen mit unterschiedlichen Ausprägungen im Kriterium diskriminieren.

Zur Absicherung der Diskriminationsfähigkeit der Items sollte das Ergebnis der Itemauswahl an einer anderen Stichprobe überprüft werden.

Internale (faktorenanalytische) Konstruktion

Hierbei werden zunächst Items konstruiert, die hypothetischen Verhaltensdimensionen erfassen sollen.

Diese werden einer Stichprobe von Personen der interessierenden Zielgruppe vorgegeben.

Im Anschluss werden die Items einer Faktorenanalyse unterzogen und aufgrund der faktorenanalytischen Ergebnisse zu „Skalen“ zusammengefasst.

Tags: Itemkonstruktion

Quelle: F51

Quelle: F51

Welche weiteren Aspekte sind bei der Itemkonstruktion und Testentwicklung noch zu beachten?

Weitere Aspekte der Itemkonstruktion und Testentwicklung, wie

sind auf den Seiten 38 – 71 des Buchs von Moosbrugger & Kelava (2008) zu finden.

- Aufgabentypen und Antwortformate

- Fehlerquellen bei der Itembeantwortung

- Gesichtspunkte der Itemformulierung

- Erstellen der vorläufigen Testversion

- Erprobung der vorläufigen Testversion

sind auf den Seiten 38 – 71 des Buchs von Moosbrugger & Kelava (2008) zu finden.

Tags: Itemkonstruktion, Testkonstruktion

Quelle: F57

Quelle: F57

Was sind die Axiome der klassischen Testtheorie?

Im Rahmen der klassischen Testtheorie gelten laut Moosbrugger & Kelava (2008)* die folgenden Axiome:

* die angeführten Axiome unterscheiden sich von den üblicherweise angeführten.

Axiome sind nicht weiter zu hinterfragende Grundannahmen.

- das Existenzaxiom,

- das Verknüpfungsaxiom und

- das Unabhängigkeitsaxiom.

* die angeführten Axiome unterscheiden sich von den üblicherweise angeführten.

Axiome sind nicht weiter zu hinterfragende Grundannahmen.

Tags: Axiome, Klassische Testtheorie

Quelle: F59

Quelle: F59

Was besagt das Existenzaxiom?

Das Existenzaxiom besagt, dass ein „wahrer Wert“ (= true score) existiert. Dieser „wahre Wert“ ist der Erwartungswert der gemessenen Leistung einer Person.

Demnach gilt

(Im Rahmen der klassischen Testtheorie gelten laut Moosbrugger & Kelava (2008) die folgenden Axiome: das Existenzaxiom, das Verknüpfungsaxiom und das Unabhängigkeitsaxiom.)

Demnach gilt

(Im Rahmen der klassischen Testtheorie gelten laut Moosbrugger & Kelava (2008) die folgenden Axiome: das Existenzaxiom, das Verknüpfungsaxiom und das Unabhängigkeitsaxiom.)

Tags: Axiome, Existenzaxiom, Klassische Testtheorie

Quelle: F60

Quelle: F60

Was ist das Verknüpfungsaxiom?

Das Verknüpfungsaxiom besagt, dass sich die gemessene Leistung einer Person aus ihrem wahren Wert und dem Messfehler zusammensetzt.

Der Messfehler spielt in der klassischen Testtheorie eine zentrale Rolle. Sie wird daher auch oft als „Messfehlertheorie“ bezeichnet.

(Im Rahmen der klassischen Testtheorie gelten laut Moosbrugger & Kelava (2008) die folgenden Axiome: das Existenzaxiom, das Verknüpfungsaxiom und das Unabhängigkeitsaxiom.)

Der Messfehler spielt in der klassischen Testtheorie eine zentrale Rolle. Sie wird daher auch oft als „Messfehlertheorie“ bezeichnet.

(Im Rahmen der klassischen Testtheorie gelten laut Moosbrugger & Kelava (2008) die folgenden Axiome: das Existenzaxiom, das Verknüpfungsaxiom und das Unabhängigkeitsaxiom.)

Tags: Axiome, Klassische Testtheorie, Verknüpfungsaxiom

Quelle: F61

Quelle: F61

Was ist das Unabhängigkeitsaxiom?

Das Unabhängigkeitsaxiom besagt, dass der „wahre Wert“ einer Person und der bei der Messung entstandene Messfehler nicht korrelieren.

(Im Rahmen der klassischen Testtheorie gelten laut Moosbrugger & Kelava (2008) die folgenden Axiome: das Existenzaxiom, das Verknüpfungsaxiom und das Unabhängigkeitsaxiom.)

(Im Rahmen der klassischen Testtheorie gelten laut Moosbrugger & Kelava (2008) die folgenden Axiome: das Existenzaxiom, das Verknüpfungsaxiom und das Unabhängigkeitsaxiom.)

Tags: Axiome, Klassische Testtheorie, Unabhängigkeitsaxiom

Quelle: F62

Quelle: F62

Welche Zusatzannahmen gibt es neben den Axiomen bei der Klassischen Testtheorie?

Da bei Messfehlertheorien im allgemeinen angenommen wird, dass es sich bei dem Messfehler um eine Zufallsvariable handelt, muss das Unabhängigkeitsaxiom erweitert werden.

Tags: Axiome, Klassische Testtheorie

Quelle: F63

Quelle: F63

Was kann aus den Axiomen der klassischen Testtheorie gefolgert werden hinsichtlich Erwartungswert des Messfehlers, Varianz und Kovarianz der gemessenen Werte?

Tags: Axiome, Erwartungswert, Klassische Testtheorie, Kovarianz, Varianz

Quelle: F64

Quelle: F64

Was versteht man unter äquivalenten Messungen? Welche vier Zugänge gibt es?

(Klassische Testtheorie)

Äquivalente Messungen

Bei den äquivalenten Messungen geht es um die Frage, welche Voraussetzungen erfüllt sein müssen, um annehmen zu können, dass zwei Tests (oder auch Items), dasselbe psychologische Merkmal messen.

Es gibt hierfür vier unterschiedlich strenge „Zugänge“:

– Replikation,

– Parallelmessung

– - äquivalente Messungen und

- äquivalente Messungen und

– essentielle -äquivalente Messungen.

-äquivalente Messungen.

Replikation

Bei der Replikation wird gefordert, dass verschiedene Messinstrumente bei derselben Person zu exakt demselben Messergebnis kommen müssen, um von einer wiederholten Messung zu sprechen. Sie stellt somit die strengsten (und für die Praxis unrealistische) Forderungen.

Parallelmessung

Um eine Parallelmessung handelt es sich, wenn zwei Tests (oder Items), denselben Erwartungswert und die selbe Varianz besitzen.

Demnach gilt bei Parallelmessungen

Parallelmessungen erfassen das gleiche psychologische Merkmal gleich genau, da die Gleichheit der Varianzen der Messwerte auch gleiche Varianzen der Messfehler bedeutet.

Ein zu Test A paralleler Test wird in weiterer Folge mit A‘ bezeichnet.

- äquivalente Messungen

- äquivalente Messungen

Um - äquivalente Messungen handelt es sich, wenn zwei Tests (oder Items), denselben Erwartungswert aber unterschiedliche Varianz besitzen.

- äquivalente Messungen handelt es sich, wenn zwei Tests (oder Items), denselben Erwartungswert aber unterschiedliche Varianz besitzen.

Demnach gilt bei - äquivalenten Messungen

- äquivalenten Messungen

- äquivalente Messungen erfassen das gleiche Merkmal verschieden genau.

- äquivalente Messungen erfassen das gleiche Merkmal verschieden genau.

Essentiell äquivalente Messungen

äquivalente Messungen

Bei essentiell - äquivalente Messungen unterscheiden sich die Erwartungswerte zweier Tests (oder Items) um eine additive Konstante. Die Varianzen können ebenfalls verschieden sein.

- äquivalente Messungen unterscheiden sich die Erwartungswerte zweier Tests (oder Items) um eine additive Konstante. Die Varianzen können ebenfalls verschieden sein.

Demnach gilt bei essentiell - äquivalenten Messungen

- äquivalenten Messungen

Äquivalente Messungen

Bei den äquivalenten Messungen geht es um die Frage, welche Voraussetzungen erfüllt sein müssen, um annehmen zu können, dass zwei Tests (oder auch Items), dasselbe psychologische Merkmal messen.

Es gibt hierfür vier unterschiedlich strenge „Zugänge“:

– Replikation,

– Parallelmessung

–

- äquivalente Messungen und

- äquivalente Messungen und– essentielle

-äquivalente Messungen.

-äquivalente Messungen.Replikation

Bei der Replikation wird gefordert, dass verschiedene Messinstrumente bei derselben Person zu exakt demselben Messergebnis kommen müssen, um von einer wiederholten Messung zu sprechen. Sie stellt somit die strengsten (und für die Praxis unrealistische) Forderungen.

Parallelmessung

Um eine Parallelmessung handelt es sich, wenn zwei Tests (oder Items), denselben Erwartungswert und die selbe Varianz besitzen.

Demnach gilt bei Parallelmessungen

Parallelmessungen erfassen das gleiche psychologische Merkmal gleich genau, da die Gleichheit der Varianzen der Messwerte auch gleiche Varianzen der Messfehler bedeutet.

Ein zu Test A paralleler Test wird in weiterer Folge mit A‘ bezeichnet.

- äquivalente Messungen

- äquivalente MessungenUm

- äquivalente Messungen handelt es sich, wenn zwei Tests (oder Items), denselben Erwartungswert aber unterschiedliche Varianz besitzen.

- äquivalente Messungen handelt es sich, wenn zwei Tests (oder Items), denselben Erwartungswert aber unterschiedliche Varianz besitzen.Demnach gilt bei

- äquivalenten Messungen

- äquivalenten Messungen

- äquivalente Messungen erfassen das gleiche Merkmal verschieden genau.

- äquivalente Messungen erfassen das gleiche Merkmal verschieden genau.Essentiell

äquivalente Messungen

äquivalente MessungenBei essentiell

- äquivalente Messungen unterscheiden sich die Erwartungswerte zweier Tests (oder Items) um eine additive Konstante. Die Varianzen können ebenfalls verschieden sein.

- äquivalente Messungen unterscheiden sich die Erwartungswerte zweier Tests (oder Items) um eine additive Konstante. Die Varianzen können ebenfalls verschieden sein.Demnach gilt bei essentiell

- äquivalenten Messungen

- äquivalenten Messungen

Tags: äquivalente Messungen, Klassische Testtheorie

Quelle: F65

Quelle: F65

Was ist die Reliabilität? Was kennzeichnet diese?

Die Reliabilität eines Tests gibt den Grad der Genauigkeit an, mit dem ein Test ein bestimmtes Merkmal misst. Im Rahmen der klassischen Testtheorie steht hierbei die Varianz des Messfehlers im Vordergrund.

Vereinfacht gesagt: Je größer die Varianz des Messfehlers desto, geringer die Reliabilität.

Je nach Autor wird eine Reliabilität ab 0.7 bzw. 0.8 als ausreichende Reliabilität angesehen.

Vereinfacht gesagt: Je größer die Varianz des Messfehlers desto, geringer die Reliabilität.

Je nach Autor wird eine Reliabilität ab 0.7 bzw. 0.8 als ausreichende Reliabilität angesehen.

Tags: Reliabilität

Quelle: F70

Quelle: F70

Welche Arten der Reliabilitätsbestimmung gibt es (im Überblick)?

Es lassen sich drei/vier Arten der Reliabilität unterscheiden

- Retest - Reliabilität

- Paralleltest – Reliabilität

- [Testhalbierungs- (Split Half-) Reliabilität]

- Innere Konsistenz

Tags: Reliabilität

Quelle: F73

Quelle: F73

Was versteht man unter der Retest-Reliabilität?

Hierbei wird derselbe Test derselben Stichprobe zweimal vorgelegt. Vorausgesetzt es gibt weder

entspricht die geschätzte Reliabilität der Korrelationen der Testergebnisse der beiden Durchgänge.

Um unsystematische Veränderungen handelt es sich, wenn die zeitlichen Veränderungen nicht bei allen Personen gleichartig sind z.B. bei manchen Personen bleibt der wahre Wert gleich bei anderen steigt er.

Bei Leistungstest ergeben sich Probleme z.B. aufgrund von Deckeneffekten.

- Veränderungen der Messfehlereinflüsse noch

- „unsystematische“ Veränderungen des wahren Werts,

entspricht die geschätzte Reliabilität der Korrelationen der Testergebnisse der beiden Durchgänge.

Um unsystematische Veränderungen handelt es sich, wenn die zeitlichen Veränderungen nicht bei allen Personen gleichartig sind z.B. bei manchen Personen bleibt der wahre Wert gleich bei anderen steigt er.

Bei Leistungstest ergeben sich Probleme z.B. aufgrund von Deckeneffekten.

Tags: Reliabilität

Quelle: F73

Quelle: F73

Was versteht man unter der Paralleltest-Reliabilität?

Hierbei werden den Personen zwei Tests vorgelegt, die parallele Messungen darstellen. Die Korrelation der Ergebnisse schätzt die Reliabilität der beiden Tests.

Probleme ergeben sich, wenn die beiden Tests nicht völlig parallel sind. Eine strenge Testung der Parallelität zweier Tests ist im Rahmen der klassischen Testtheorie nicht möglich.

Die eleganteste Prüfung der Parallelität von Tests ohne auf die moderne Testtheorie zurückzugreifen, stellen konfirmatorische Faktorenanalysen dar.

Probleme ergeben sich, wenn die beiden Tests nicht völlig parallel sind. Eine strenge Testung der Parallelität zweier Tests ist im Rahmen der klassischen Testtheorie nicht möglich.

Die eleganteste Prüfung der Parallelität von Tests ohne auf die moderne Testtheorie zurückzugreifen, stellen konfirmatorische Faktorenanalysen dar.

Tags: Reliabilität

Quelle: F74

Quelle: F74

Was ist die Testhalbierungs-Reliabilität (Split-Half Reliabilität)?

Hierbei wird ein aus mehreren Items bestehender Test in zwei möglichst parallele Untertests geteilt. Die Korrelation der Ergebnisse der beiden Untertests schätzt die Reliabilität des halb so langen Tests. Um auf die geschätzte Reliabilität des Gesamttests zu kommen, wird auf einen Spezialfall der Formel von Spearman-Brown* zurückgegriffen.

Tags: Reliabilität

Quelle: F75

Quelle: F75

Was ist die Innere Konsistenz?

Methode zur Feststellung der Reliabilität

Hierbei wird jedes Item eines aus mehreren Items bestehenden Tests als eigene Messung des interessierenden Merkmals betrachtet. Die innere Konsistenz kann dann vereinfacht als durchschnittliche Korrelation aller Items dieses Tests verstanden werden, hängt aber auch von der Anzahl an Items im Test ab.

Die bekanntesten Kennwerte zur inneren Konsistenz sind

Stellen die Items zumindest essentiell - äquivalente Messungen dar, sind

- äquivalente Messungen dar, sind  und

und  3 Schätzungen der Reliabilität des Gesamttests.

3 Schätzungen der Reliabilität des Gesamttests.

Für den Fall, dass die Items keine äquivalenten Messungen darstellen, sind und

und  3 lediglich untere Schranken der Reliabilität.

3 lediglich untere Schranken der Reliabilität.

WICHTIG

Hierbei wird jedes Item eines aus mehreren Items bestehenden Tests als eigene Messung des interessierenden Merkmals betrachtet. Die innere Konsistenz kann dann vereinfacht als durchschnittliche Korrelation aller Items dieses Tests verstanden werden, hängt aber auch von der Anzahl an Items im Test ab.

Die bekanntesten Kennwerte zur inneren Konsistenz sind

- Cronbach

- Lambda3 nach Guttman

Stellen die Items zumindest essentiell

- äquivalente Messungen dar, sind

- äquivalente Messungen dar, sind  und

und  3 Schätzungen der Reliabilität des Gesamttests.

3 Schätzungen der Reliabilität des Gesamttests.Für den Fall, dass die Items keine äquivalenten Messungen darstellen, sind

und

und  3 lediglich untere Schranken der Reliabilität.

3 lediglich untere Schranken der Reliabilität.WICHTIG

- bei der Berechnung von

und

und  3 müssen die Items gleichartig „gepolt“ sein, d.h. hohe Werte müssen inhaltlich immer dieselbe Bedeutung haben (z.B. für eine hohe Ausprägung des Merkmals sprechen)

3 müssen die Items gleichartig „gepolt“ sein, d.h. hohe Werte müssen inhaltlich immer dieselbe Bedeutung haben (z.B. für eine hohe Ausprägung des Merkmals sprechen) - Weder

noch

noch  3 sind ein Maß für die „Eindimensionalität“ von Items

3 sind ein Maß für die „Eindimensionalität“ von Items

Tags: Reliabilität

Quelle: F76

Quelle: F76

Was kann man mit der Formel nach Spearman-Brown berechnen?

Für den Fall paralleler Items, kann aus der Kenntnis der Reliabilität eines Tests, die Reliabilität des um parallele Items verlängerten bzw. verkürzten Tests mittels der Formel von Spearman-Brown berechnet werden.

Tags: Reliabilität, Spearman-Brown

Quelle: F82

Quelle: F82

Ein Test besteht aus 30 parallelen Items.

Die Reliabilität des Tests beträgt rel=0.67

Wie hoch ist die Reliabilität, wenn man den Test um 10 parallele Items verlängert?

Die Reliabilität des Tests beträgt rel=0.67

Wie hoch ist die Reliabilität, wenn man den Test um 10 parallele Items verlängert?

Tags: Reliabilität, Spearman-Brown

Quelle: F83

Quelle: F83

Ein Test besteht aus 30 parallelen Items.

Die Reliabilität des Tests beträgt rel=0.67

Wie viele Items mehr benötigt der Test, wenn man eine Reliabilität von 0.73 anstrebt?

Die Reliabilität des Tests beträgt rel=0.67

Wie viele Items mehr benötigt der Test, wenn man eine Reliabilität von 0.73 anstrebt?

Tags: Reliabilität, Spearman-Brown

Quelle: F84

Quelle: F84

Wie verändern sich Mittelwert und Varianz bei der Verlängerung/Verkürzung von Tests?

Verlängert oder verkürzt man einen Test um parallele Items, können Mittelwert und Varianz des veränderten Tests aus Kenntnis der Kennwerte des Originaltests mittels der nachfolgenden Formeln errechnet werden.

verlängerter Test - Mittelwert höher

verkürzter Test - Mittelwert kleiner

verlängerter Test - Mittelwert höher

verkürzter Test - Mittelwert kleiner

Was ist die anzustrebende Höhe der Reliabilität? Welche Punkte sind zu berücksichtigen?

Allgemein: so hoch wie möglich.

Es sind jedoch die nachfolgenden Punkte zu berücksichtigen

Art des zu erfassenden Merkmals

Leistungsvariablen sind meist präziser messbar als z.B. Einstellungen oder Persönlichkeitseigenschaften. Bei etablierten Intelligenztests sind Reliabilitäten der globalen Maße oft über 0.90, während Persönlichkeitsfragebogen Skalen oft nur Reliabilitäten um 0.7 aufweisen.

Bei heterogenen Merkmalen kann die innere Konsistenz deutlich geringer sein als z.B. die Retest- oder Paralleltest Reliabilität.

Individual- versus Kollektivdiagnostik

Bei Individualdiagnostik sollte Messgenauigkeit höher sein als bei Messung der Durchschnittleistung eines Kollektivs, da sich die Messfehler bei der Zusammenfassung von Messungen mehrerer Individuen „reduzieren“.

Einsatzbedingungen

Bei Tests, die nicht adaptiv* vorgegeben werden können, hängt die Reliabilität relativ stark von der Testlänge ab.

Daher weisen Tests und Fragebögen, die zum Screening eingesetzt werden und daher eher kurz sind, meist eine geringere Reliabilität auf.

*adaptive Testvorgaben werden im Rahmen der Einheiten zur modernen Testtheorie behandelt

Es sind jedoch die nachfolgenden Punkte zu berücksichtigen

- Art des zu erfassenden Merkmals

- Individual- versus Kollektivdiagnostik

- Einsatzbedingungen

- Kosten-Nutzen Abwägungen

- Objektivierbarkeit

Art des zu erfassenden Merkmals

Leistungsvariablen sind meist präziser messbar als z.B. Einstellungen oder Persönlichkeitseigenschaften. Bei etablierten Intelligenztests sind Reliabilitäten der globalen Maße oft über 0.90, während Persönlichkeitsfragebogen Skalen oft nur Reliabilitäten um 0.7 aufweisen.

Bei heterogenen Merkmalen kann die innere Konsistenz deutlich geringer sein als z.B. die Retest- oder Paralleltest Reliabilität.

Individual- versus Kollektivdiagnostik

Bei Individualdiagnostik sollte Messgenauigkeit höher sein als bei Messung der Durchschnittleistung eines Kollektivs, da sich die Messfehler bei der Zusammenfassung von Messungen mehrerer Individuen „reduzieren“.

Einsatzbedingungen

Bei Tests, die nicht adaptiv* vorgegeben werden können, hängt die Reliabilität relativ stark von der Testlänge ab.

Daher weisen Tests und Fragebögen, die zum Screening eingesetzt werden und daher eher kurz sind, meist eine geringere Reliabilität auf.

*adaptive Testvorgaben werden im Rahmen der Einheiten zur modernen Testtheorie behandelt

Tags: Reliabilität

Quelle: F86

Quelle: F86

Was ist der Zusammenhang zwischen Reliabilität und Konfidenzintervallen? Welche Arten von Konfidenzintervallen gibt es?

Reliabilität und Konfidenzintervalle für

Da die Reliabilität als Maß für die Genauigkeit der Messung des wahren Werts einer Person verstanden werden kann, ist sie Basis für die Erstellung von Konfidenzintervallen für wahre Werte.

Es gibt zwei Arten von Konfidenzintervallen

– auf Basis der Messfehlervarianz

– auf Basis der Schätzfehlervarianz

Da die Reliabilität als Maß für die Genauigkeit der Messung des wahren Werts einer Person verstanden werden kann, ist sie Basis für die Erstellung von Konfidenzintervallen für wahre Werte.

Es gibt zwei Arten von Konfidenzintervallen

– auf Basis der Messfehlervarianz

– auf Basis der Schätzfehlervarianz

Tags: Konfidenzintervalle, Reliabilität

Quelle: F90

Quelle: F90

Wie kann die Messfehlervarianz berechnet werden?

KI auf Basis der Messfehlervarianz

Bei Vorliegen der Varianz der Testwerte und der Reliabilität kann die Messfehlervarianz berechnet werden.

Bei Vorliegen der Varianz der Testwerte und der Reliabilität kann die Messfehlervarianz berechnet werden.

Tags: Konfidenzintervalle, Reliabilität

Quelle: F91

Quelle: F91

Wie kann der geschätzte wahre Wert und die Schätzfehlervarianz berechnet werden?

KI auf Basis der Schätzfehlervarianz

Tags: Konfidenzintervalle, Reliabilität, Varianz

Quelle: F92

Quelle: F92

Eine Person erzielt in einem Test 43 Punkte. Es ist bekannt, dass der Mittelwert des Tests 39 Punkte, die Standardabweichung des Tests 5 Punkte und die Reliabilität rel= 0.85 beträgt.

In welchem Bereich befindet sich der wahre Wert der Person mit 99%iger Sicherheit?

In welchem Bereich befindet sich der wahre Wert der Person mit 99%iger Sicherheit?

Tags: Mittelwert, Reliabilität, Standardabweichung, Varianz

Quelle: F93

Quelle: F93

Eine Person erzielt in einem Test einen IQ von 134. Die im Testmanual angegebene Testreliabilität beträgt rel= 0.75.

Kann man mit 95%iger Sicherheit davon ausgehen, dass die Person einen „wahren“ IQ über 130 hat und somit hochbegabt ist?

Bemerkung: die Standardabweichung des IQ ist laut Normtabellen auf 15 festgelegt

Kann man mit 95%iger Sicherheit davon ausgehen, dass die Person einen „wahren“ IQ über 130 hat und somit hochbegabt ist?

Bemerkung: die Standardabweichung des IQ ist laut Normtabellen auf 15 festgelegt

Tags: Konfidenzintervalle, Reliabilität

Quelle: F94

Quelle: F94

Was versteht man unter Validität?

Definition

Ein Test gilt dann als valide („gültig“), wenn er das Merkmal, das er messen soll, auch wirklich misst.

(angelehnt an Moosbrugger & Kelava, 2008, S. 13)

ABER:

Woran ist erkennbar welches Merkmal ein Test misst?

Anstatt von der „Validität eines Tests“ zu sprechen, sollte die Validität möglicher Interpretationen von Testergebnissen betrachtet werden.

(vergl. Moosbrugger & Kelava, 2008,S.136)

Ein Test gilt dann als valide („gültig“), wenn er das Merkmal, das er messen soll, auch wirklich misst.

(angelehnt an Moosbrugger & Kelava, 2008, S. 13)

ABER:

Woran ist erkennbar welches Merkmal ein Test misst?

Anstatt von der „Validität eines Tests“ zu sprechen, sollte die Validität möglicher Interpretationen von Testergebnissen betrachtet werden.

(vergl. Moosbrugger & Kelava, 2008,S.136)

Tags: Validität

Quelle: F95

Quelle: F95

Auf was können sich die verschiedenen Interpretationen eines Testergebnisses beziehen?

Verschiedene Interpretationen des Testergebnisses können sich beziehen auf

Entscheidungen als Folge des Testergebnisses ergeben.

Vor der Validierung muss überlegt werden, welche der oben angeführten Bereiche betrachtet werden sollen.

- die Bewertung des Endergebnisses,

- das Verallgemeinern des Ergebnisses,

- die Extrapolation auf andere Bereiche,

- das (kausale) Erklären und

- mögliche Konsequenzen, die sich durch das Treffen von

Entscheidungen als Folge des Testergebnisses ergeben.

Vor der Validierung muss überlegt werden, welche der oben angeführten Bereiche betrachtet werden sollen.

Tags: Validität

Quelle: F96

Quelle: F96

Welche Arten von Merkmalsdefinitionen können unterschieden werden?

(Validität)

Neben der Überlegung, welcher Bereich validiert werden soll, ist zu überlegen, auf welcher Definition das zu erfassende Merkmal basiert.

Moosbrugger & Kelava unterscheiden zwischen zwei Merkmalsdefinitionen

Die Grenzen zwischen den beiden Definitionen sind allerdings fließend.

Operationale Merkmalsdefinition

Um eine operationale Merkmalsdefinition handelt es sich, wenn die Testaufgaben den interessierenden Anforderungsbereich direkt repräsentieren.

Ein operational definiertes Merkmal bezieht sich zunächst nur auf die spezifischen Test- bzw. Merkmalsinhalte.

z.B.:

Theoretische Merkmalsdefinition

Bei theoretischen Merkmalsdefinitionen werden Theorien herangezogen, die spezifizieren (verdeutlichen), worauf bestimmte Unterschiede zwischen Personen zurückgeführt werden können und wie sich diese Unterschiede in den Testergebnissen ausdrücken.

z.B. formuliert Eysenck (1981) Annahmen darüber, in welchen neuronalen Strukturen sich Personen mit unterschiedlichen Ausprägungen der Persönlichkeitsdimension Extraversion unterscheiden. Daraus leitet er Unterschiede in bestimmten Erlebens- und Verhaltensweisen ab, auf die sich dann die Items, die zur Erfassung der Extraversion herangezogen werden, beziehen.

Neben der Überlegung, welcher Bereich validiert werden soll, ist zu überlegen, auf welcher Definition das zu erfassende Merkmal basiert.

Moosbrugger & Kelava unterscheiden zwischen zwei Merkmalsdefinitionen

- operational und

- theoretisch.

Die Grenzen zwischen den beiden Definitionen sind allerdings fließend.

Operationale Merkmalsdefinition

Um eine operationale Merkmalsdefinition handelt es sich, wenn die Testaufgaben den interessierenden Anforderungsbereich direkt repräsentieren.

Ein operational definiertes Merkmal bezieht sich zunächst nur auf die spezifischen Test- bzw. Merkmalsinhalte.

z.B.:

- Test zur Erfassung des Kurzzeitgedächtnisses

- Fragebogen zur Einschätzung der Sicherheit von Atomkraftwerken

Theoretische Merkmalsdefinition

Bei theoretischen Merkmalsdefinitionen werden Theorien herangezogen, die spezifizieren (verdeutlichen), worauf bestimmte Unterschiede zwischen Personen zurückgeführt werden können und wie sich diese Unterschiede in den Testergebnissen ausdrücken.

z.B. formuliert Eysenck (1981) Annahmen darüber, in welchen neuronalen Strukturen sich Personen mit unterschiedlichen Ausprägungen der Persönlichkeitsdimension Extraversion unterscheiden. Daraus leitet er Unterschiede in bestimmten Erlebens- und Verhaltensweisen ab, auf die sich dann die Items, die zur Erfassung der Extraversion herangezogen werden, beziehen.

Tags: Merkmal, Merkmalsdefinition, Validität

Quelle: F97

Quelle: F97

Welche Arten von Validität können unterschieden werden (im Überblick)? Welche weiteren Begriffe werden häufig im Zusammenhang mit Validität gebracht?

Im Wesentlichen werden vier Arten der Validität unterschieden

Weitere, häufig zu findende Begriffe im Zusammenhang mit Validität sind

- Inhaltsvalidität,

- Augenscheinvalidität,

- Kriteriumsvalidität und

- Konstruktvalidität.

Weitere, häufig zu findende Begriffe im Zusammenhang mit Validität sind

- Übereinstimmungsvalidität,

- prognostische Validität,

- diskriminante Validität und

- konvergente Validität.

Tags: Validität

Quelle: F100

Quelle: F100

Was versteht man unter Inhaltsvalidität?

Inhaltsvalidität bezieht sich darauf, inwieweit die Inhalte der Tests bzw. der Items, aus denen sich ein Test zusammensetzt, tatsächlich das interessierende Merkmal erfassen.

(vergl. Moosbrugger & Kelava, 2008, S.140)

Bei operationalisierten Merkmalen bezieht sich die Inhaltsvalidität vor allem auf die Verallgemeinerbarkeit der Testergebnisse. Es geht also darum, inwieweit die ausgewählte Items eine repräsentative Auswahl aus der Menge aller möglicher Aufgaben sind.

z.B. Wie gut decken die Fragen, die bei der Testtheorieprüfung gestellt werden, das vorgetragene Stoffgebiet ab?

Auch bei theoretisch definierten Merkmalen muss die Verallgemeinerung auf eine größere Menge von Aufgaben möglich sein. Zusätzlich muss angenommen werden können, dass unterschiedliche Antworten Unterschiede im interessierenden Merkmal erklären können.

Das bedeutet, es muss von den Antworten auf die Items auf das interessierende Merkmal geschlossen werden können.

Dies kann nur durch eine gute theoretische Fundierung und eine daran orientierte Itemkonstruktion gewährleistet werden.

(vergl. Moosbrugger & Kelava, 2008, S.140)

Bei operationalisierten Merkmalen bezieht sich die Inhaltsvalidität vor allem auf die Verallgemeinerbarkeit der Testergebnisse. Es geht also darum, inwieweit die ausgewählte Items eine repräsentative Auswahl aus der Menge aller möglicher Aufgaben sind.

z.B. Wie gut decken die Fragen, die bei der Testtheorieprüfung gestellt werden, das vorgetragene Stoffgebiet ab?

Auch bei theoretisch definierten Merkmalen muss die Verallgemeinerung auf eine größere Menge von Aufgaben möglich sein. Zusätzlich muss angenommen werden können, dass unterschiedliche Antworten Unterschiede im interessierenden Merkmal erklären können.

Das bedeutet, es muss von den Antworten auf die Items auf das interessierende Merkmal geschlossen werden können.

Dies kann nur durch eine gute theoretische Fundierung und eine daran orientierte Itemkonstruktion gewährleistet werden.

Tags: Validität

Quelle: F101

Quelle: F101

Was versteht man unter Augenscheinvalidität?

Augenscheinvalidität gibt an, inwieweit der Validitätsanspruch eines Tests vom bloßen Augenschein her einem Laien gerechtfertigt erscheint.

(Moosbrugger & Kelava, 2008 S.15)

(Moosbrugger & Kelava, 2008 S.15)

Tags: Validität

Quelle: F104

Quelle: F104

Was versteht man unter Konstruktvalidität? Wie wird diese untersucht?

Konstruktvalidität umfasst die empirischen Befunde und Argumente, mit denen die Zuverlässigkeit der Interpretation von Testergebnissen im Sinne erklärender Konzepte, die sowohl Testergebnisse als auch Zusammenhänge der Testwerte mit anderen Variablen erklären, gestützt wird.

(Messick, 1995, S.743, Übersetzung J. Hartig & A. Frey;

aus Moosbrugger & Kelava, 2008, S. 145)

Auf die Konstruktvalidität wird im Zuge der Faktorenanalyse nochmals eingegangen

Im Wesentlichen geht es darum, Testergebnisse vor dem Hintergrund eines theoretischen Konstrukts zu interpretieren.

Man unterscheidet zwischen

Der Bereich der Theorie beschäftigt sich mit nicht direkt beobachtbaren (=latenten) Konstrukten und deren Zusammenhängen. Im Idealfall sind diese Zusammenhänge durch Axiome formalisiert.

Korrespondenzregeln geben an, wie sich die theoretischen Zusammenhänge auf den Bereich des Beobachtbaren auswirken.

Bei diesen „Auswirkungen“ handelt es sich meist um Zusammenhänge zwischen manifesten Variablen mitunter aber auch um Unterschiede zwischen Gruppen.

Diese Zusammenhänge bzw. Unterschiede werden in weiterer Folge empirisch geprüft.

Stimmen die theoretische Vorhersagen mit den empirischen Beobachtungen überein, wird das als Bestätigung der Theorie als auch der Interpretation der Testkennwerte als individuelle Ausprägung auf dem theoretischen Konstrukt angesehen.

Für den Fall, dass eine relativ hohe Korrelation erwartet wird, spricht man von konvergenter Validität (z.B. Korrelation mit einem Test der dasselbe Konstrukt messen soll).

Falls man eine niedrige Korrelation erwartet, spricht man von diskriminanter Validität. (z.B. Korrelation mit einem Test, der ein anderes Konstrukt erfassen soll).

Weitere Methoden zur Untersuchung der Konstruktvalidität sind

Bei der Analyse von Antwortprozessen können Personen z.B. gebeten werden, bei der Bearbeitung der Aufgaben laut zu denken, um so Annahmen über Antwortprozesse zu erheben bzw. zu klären, ob sich die Antwortprozesse auf das gewünschte Konstrukt beziehen.

(Messick, 1995, S.743, Übersetzung J. Hartig & A. Frey;

aus Moosbrugger & Kelava, 2008, S. 145)

Auf die Konstruktvalidität wird im Zuge der Faktorenanalyse nochmals eingegangen

Im Wesentlichen geht es darum, Testergebnisse vor dem Hintergrund eines theoretischen Konstrukts zu interpretieren.

Man unterscheidet zwischen

- dem Bereich der Theorie und

- dem Bereich der Beobachtung.

Der Bereich der Theorie beschäftigt sich mit nicht direkt beobachtbaren (=latenten) Konstrukten und deren Zusammenhängen. Im Idealfall sind diese Zusammenhänge durch Axiome formalisiert.

Korrespondenzregeln geben an, wie sich die theoretischen Zusammenhänge auf den Bereich des Beobachtbaren auswirken.

Bei diesen „Auswirkungen“ handelt es sich meist um Zusammenhänge zwischen manifesten Variablen mitunter aber auch um Unterschiede zwischen Gruppen.

Diese Zusammenhänge bzw. Unterschiede werden in weiterer Folge empirisch geprüft.

Stimmen die theoretische Vorhersagen mit den empirischen Beobachtungen überein, wird das als Bestätigung der Theorie als auch der Interpretation der Testkennwerte als individuelle Ausprägung auf dem theoretischen Konstrukt angesehen.

Für den Fall, dass eine relativ hohe Korrelation erwartet wird, spricht man von konvergenter Validität (z.B. Korrelation mit einem Test der dasselbe Konstrukt messen soll).

Falls man eine niedrige Korrelation erwartet, spricht man von diskriminanter Validität. (z.B. Korrelation mit einem Test, der ein anderes Konstrukt erfassen soll).

Weitere Methoden zur Untersuchung der Konstruktvalidität sind

- Analysen von Antwortprozessen und

- der Vergleich von theoretisch erwarteten Itemschwierigkeiten mit empirisch ermittelten.

Bei der Analyse von Antwortprozessen können Personen z.B. gebeten werden, bei der Bearbeitung der Aufgaben laut zu denken, um so Annahmen über Antwortprozesse zu erheben bzw. zu klären, ob sich die Antwortprozesse auf das gewünschte Konstrukt beziehen.

Tags: Validität

Quelle: F105

Quelle: F105

Was versteht man unter Kriteriumsvalidität?

Kriteriumsvalidität bedeutet, dass von einem Testergebnis, auf ein für diagnostische Entscheidungen praktisch relevantes Kriterium außerhalb der Testsituation geschlossen werden kann. Kriteriumsvalidität kann durch empirische Zusammenhänge zwischen dem Testwert und möglichen Außenkriterien belegt werden. Je enger diese Zusammenhänge, desto besser kann die Kriteriumsvalidität als belegt gelten.

(Moosbrugger & Kelava, 2008, S. 156)

Von größter Bedeutung ist hierbei die Frage, welche Außenkriterien gewählt werden.

Die Auswahl sollte gut begründet und nachvollziehbar sein.

Kann ein theoretisch hergeleiteter Zusammenhang von Testergebnis und Außenkriterium empirisch untermauert werden, wird dadurch sowohl die Validität der theoriebasierten Testwertinterpretation als auch die Validität der diagnostischen Entscheidung unterstützt.

Außenkriterien können

(Moosbrugger & Kelava, 2008, S. 156)

Von größter Bedeutung ist hierbei die Frage, welche Außenkriterien gewählt werden.

Die Auswahl sollte gut begründet und nachvollziehbar sein.

Kann ein theoretisch hergeleiteter Zusammenhang von Testergebnis und Außenkriterium empirisch untermauert werden, wird dadurch sowohl die Validität der theoriebasierten Testwertinterpretation als auch die Validität der diagnostischen Entscheidung unterstützt.

Außenkriterien können

- zeitlich parallel existieren (Übereinstimmungsvalidität) oder

- sich auf zukünftige Ausprägungen eins Merkmals beziehen (prognostische Validität).

Tags: Validität

Quelle: F110

Quelle: F110

Wie kann die Kriteriumsvalidität berechnet werden? Welches Problem tritt dabei auf? Welche Formel muss hier angewendet werden?

Die praktische Berechnung der Kriteriumsvalidität erfolgt durch die Berechnung der Korrelation von Testergebnis (X) mit dem Außenkriterium (Y).

Problematisch dabei ist, dass die Validität durch zwei Messfehler „verdünnt“ wird. Sie fällt also aufgrund der Messfehler, die bei der Messung des Testergebnisses und des Außenkriteriums auftreten, geringer aus, als sie in „Wirklichkeit“ wäre.

Verdünnungsformeln

Um diesen Fehler auszugleichen, gibt es je nachdem welche(r) Messfehler theoretisch beseitigt werden soll, drei Verdünnungsformeln*

*die Verdünnungsformeln können natürlich auch im Zuge der Berechnung von Konstruktvaliditäten angewandt werden

Problematisch dabei ist, dass die Validität durch zwei Messfehler „verdünnt“ wird. Sie fällt also aufgrund der Messfehler, die bei der Messung des Testergebnisses und des Außenkriteriums auftreten, geringer aus, als sie in „Wirklichkeit“ wäre.

Verdünnungsformeln

Um diesen Fehler auszugleichen, gibt es je nachdem welche(r) Messfehler theoretisch beseitigt werden soll, drei Verdünnungsformeln*

*die Verdünnungsformeln können natürlich auch im Zuge der Berechnung von Konstruktvaliditäten angewandt werden

Tags: Validität, Verdünnungsformel

Quelle: F113

Quelle: F113

Die Korrelation eines Tests X mit einem Außenkriterium Y sei r(X,Y)=0.47. Es sei bekannt, dass die Reliabilität des Tests 0.64 und die des Außenkriteriums 0.49 beträgt.

Wie hoch wäre die Validität des Tests, wenn man das Außenkriterium fehlerfrei erheben könnte?

Wie hoch wäre die Validität des Tests, wenn man das Außenkriterium fehlerfrei erheben könnte?

Tags: Validität, Verdünnungsformel

Quelle: F116

Quelle: F116

Die Korrelation eines Tests X mit einem Außenkriterium Y sei

r(X,Y)=0.47. Es sei bekannt, dass die Reliabilität des Tests

0.64 und die des Außenkriteriums 0.49 beträgt.

Wie hoch wäre die Validität des Tests, wenn man das

Testergebnis fehlerfrei messen könnte?

r(X,Y)=0.47. Es sei bekannt, dass die Reliabilität des Tests

0.64 und die des Außenkriteriums 0.49 beträgt.

Wie hoch wäre die Validität des Tests, wenn man das

Testergebnis fehlerfrei messen könnte?

Tags: Validität, Verdünnungsformel

Quelle: F117

Quelle: F117

Die Korrelation eines Tests X mit einem Außenkriterium Y sei r(X,Y)=0.47. Es sei bekannt, dass die Reliabilität des Tests 0.64 und die des Außenkriteriums 0.49 beträgt.

Wie hoch wäre die Validität des Tests, wenn man sowohl den Test als auch das Außenkriterium fehlerfrei messen könnte?

Wie hoch wäre die Validität des Tests, wenn man sowohl den Test als auch das Außenkriterium fehlerfrei messen könnte?

Tags: Validität, Verdünnungsformel

Quelle: F118

Quelle: F118

Wie kann eine Kosten-Nutzen-Abwägung eines Tests erfolgen?

Ist die Validität eines Tests bekannt, kann damit der Nutzen der Anwendung eines Tests zur Personenselektion ermittelt werden.

Hierfür können die sogenannten Taylor- Russell Tafeln herangezogen werden.

Anhand der Taylor Russell Tafeln ist für tabellierte Grund- und Selektionsraten sowie bei gegebener Validität des Tests ablesbar, wie hoch der Anteil „wirklich geeigneter“ Personen ist, sofern sie aufgrund des Testergebnisses als „geeignet“ angesehen werden.

Hierfür können die sogenannten Taylor- Russell Tafeln herangezogen werden.

Anhand der Taylor Russell Tafeln ist für tabellierte Grund- und Selektionsraten sowie bei gegebener Validität des Tests ablesbar, wie hoch der Anteil „wirklich geeigneter“ Personen ist, sofern sie aufgrund des Testergebnisses als „geeignet“ angesehen werden.

Tags: Kosten-Nutzen, Taylor-Russell-Tafeln, Validität

Quelle: F119

Quelle: F119

Was ist die Grundidee der Taylor-Russel Tafeln?

Die Grundidee der Taylor Russel Tafeln besteht darin, dass angenommen wird, dass ein Individuum über eine bestimmte Mindestausprägung des zu erhebenden Merkmals verfügen muss, um für eine bestimmte Anforderung geeignet zu sein.

Je nachdem wie hoch diese Mindestausprägung ist, ist nur ein gewisser Prozentsatz der „relevanten“ Population „wirklich geeignet“. Dieser Prozentsatz nennt sich Grundrate (GR) bzw. Grundquote (GQ)

Weiters wird aufgrund des Testergebnisses ein bestimmter Teil der getesteten Personen als geeignet betrachtet. Dieser Anteil nennt sich Selektionsrate (SR) oder Selektionsquote (SQ).

Anhand der Taylor Russell Tafeln ist für tabellierte Grund und Selektionsraten sowie bei gegebener Validität des Tests ablesbar, wie hoch der Anteil „wirklich geeigneter“ Personen ist, sofern sie aufgrund des Testergebnisses als „geeignet“ angesehen werden (rosa Bereich).

Je nachdem wie hoch diese Mindestausprägung ist, ist nur ein gewisser Prozentsatz der „relevanten“ Population „wirklich geeignet“. Dieser Prozentsatz nennt sich Grundrate (GR) bzw. Grundquote (GQ)

Weiters wird aufgrund des Testergebnisses ein bestimmter Teil der getesteten Personen als geeignet betrachtet. Dieser Anteil nennt sich Selektionsrate (SR) oder Selektionsquote (SQ).

Anhand der Taylor Russell Tafeln ist für tabellierte Grund und Selektionsraten sowie bei gegebener Validität des Tests ablesbar, wie hoch der Anteil „wirklich geeigneter“ Personen ist, sofern sie aufgrund des Testergebnisses als „geeignet“ angesehen werden (rosa Bereich).

Tags: Taylor-Russell-Tafeln, Validität

Quelle: F120

Quelle: F120

Was zeigt diese Grafik?

- X-Achse: Testergebnis der Person

- Y-Achse: Merkmalsausprägung: Das Merkmal das wir messen wollen (z.B. Eignung für das Psychologiestudium)

- Gelb: idealisiertes Streudiagramm der gesamten Population

- Rote gepunktete Linie: Die Personen müssen hinsichtlich der Merkmalsausprägung über der Linie liegen. (Grundquote) - Rote Fläche: Leute die in Wirklichkeit geeignet sind.

- Grüne gepunktete Linie: Wenn die Person hinsichtlich des Testergebnisses über dieser Linie liegen, dann heißt dies, dass diese Personen laut dem Test geeignet sind. - Blaue Fläche: Leute die laut dem Test geeignet sind.

Es gibt einen Bereich/Gruppe an Personen die vom Test als geeignet gewählt werden, aber eigentlich nicht wirklich geeignet sind.

Der Überschneidungsbereich (rosa) beinhaltet alle Personen die geeignet sind und der Test als geeignet auswählt. (Bedingte Wahrscheinlichkeit)

Tags: Taylor-Russell-Tafeln, Validität

Quelle: F125

Quelle: F125

Inwiefern verändert die Validität die Form des Streudiagrams?

Die Validität bedingt die Form des Streudiagramms

- Die Ellipse symbolisiert die Korrelation zwischen der X-Variable (Testergebnis) und Y-Variable (Außenkriterium, Merkmal).

- Diese Validität ist die Kriteriumsvalidität. - Ist die Validität 0, dann ist das Streudiagramm eher rund. (kein Zusammenhang zwischen Testergebnis und Außenkriterium.- Ist die Validität 0,9, dann wird die Ellipse immer dünner.Der Anteil derer die durch den Test ausgewählt werden und tatsächlich geeignet sind wird immer höher.

Tags: Taylor-Russell-Tafeln, Validität

Quelle: F127

Quelle: F127

Was bedeutet ein Grundrate von 0,1?

Jeder 10. Ist geeignet (10% der Population).

(Taylor-Russel-Tafeln)

(Taylor-Russel-Tafeln)

Tags: Taylor-Russell-Tafeln, Validität

Quelle: F128

Quelle: F128

Was zeigt die Taylor-Russel-Tafel? (Spalten/Zeilen)

- Spaltenüberschrift – Selektionsrate: 0.05 – nur 5% der Personen die getestet werden, werden als geeignet anerkannt.

- Zeilenüberschrift (r): Validität des Tests

- In den Zellen: Wie viel Prozent der Personen die vom Test ausgewählt wurden sind tatsächlich geeignet.

Wenn man keinen Test nimmt und blind jemanden nimmt (raten), dann ist die Wahrscheinlichkeit die korrekte Person zu bekommen die Grundrate.

Tags: Taylor-Russell-Tafeln

Quelle: F128

Quelle: F128

Es sei bekannt, dass 40 % jener Personen, die sich für eine

Stelle bewerben auch wirklich dafür geeignet sind. Zur

Auswahl der Personen wird ein Test mit einer Validität von

val=0.20 verwendet.

a) Wie hoch ist die Wahrscheinlichkeit, dass die aus 20

BewerberInnen aufgrund des Tests ausgewählte Person

wirklich für die ausgeschriebene Stelle geeignet ist?

b) Wie hoch ist die Wahrscheinlichkeit eine geeignete

Person zu erhalten, wenn die Auswahl der Person nicht

aufgrund der Testergebnisse, sondern zufällig erfolgt?

Stelle bewerben auch wirklich dafür geeignet sind. Zur

Auswahl der Personen wird ein Test mit einer Validität von

val=0.20 verwendet.

a) Wie hoch ist die Wahrscheinlichkeit, dass die aus 20

BewerberInnen aufgrund des Tests ausgewählte Person

wirklich für die ausgeschriebene Stelle geeignet ist?

b) Wie hoch ist die Wahrscheinlichkeit eine geeignete

Person zu erhalten, wenn die Auswahl der Person nicht

aufgrund der Testergebnisse, sondern zufällig erfolgt?

a)

Lösung: GR= 0.40 SR=1/20=0.05 val=0.20

=> 0.57

b) Lösung: die Grundrate (hier 0.40)

Lösung: GR= 0.40 SR=1/20=0.05 val=0.20

=> 0.57

b) Lösung: die Grundrate (hier 0.40)

Tags: Taylor-Russell-Tafeln, Validität

Quelle: F129

Quelle: F129

Es sei bekannt, dass 40 % jener Personen, die sich für eine

Stelle bewerben auch wirklich dafür geeignet sind.

Wie hoch müsste die Validität sein, damit die

Wahrscheinlichkeit, dass eine aus 20 BewerberInnen

aufgrund des Tests ausgewählte Person, auch wirklich

geeignet ist, 95 % beträgt?

Stelle bewerben auch wirklich dafür geeignet sind.

Wie hoch müsste die Validität sein, damit die

Wahrscheinlichkeit, dass eine aus 20 BewerberInnen

aufgrund des Tests ausgewählte Person, auch wirklich

geeignet ist, 95 % beträgt?

Lösung: GR=0.40 SR=1/20=0.05 % - Satz=0.95

=> val= 0.70

=> val= 0.70

Tags: Taylor-Russell-Tafeln, Validität

Quelle: F132

Quelle: F132

Welche Grundannahme ist bei der Berechnung der Validität oder Reliabilität eines verkürzten/verlängerten Tests zu berücksichtigen?

Bei der Verkürzung eines Tests darf die Validität und Reliabilität nicht größer werden (und umgekehrt). Falls dies bei der Berechnung trotzdem herauskommt, dann soll dies angemerkt werden.

Tags: Reliabilität, Validität

Quelle: F133

Quelle: F133

Ein Test besteht aus 30 parallelen Items.

Die Reliabilität des Tests beträgt rel=0.67, die Validität ist 0.43.

Wie hoch ist die Validität, wenn man den Test um 10 parallele

Items verkürzt?

Die Reliabilität des Tests beträgt rel=0.67, die Validität ist 0.43.

Wie hoch ist die Validität, wenn man den Test um 10 parallele

Items verkürzt?

Tags: Validität

Quelle: F134

Quelle: F134

Was ist die Grundidee der Faktorenanalyse (einfaktoriell)?

Ziel der Faktorenanalyse: Fragen/Items die das Selbe erfassen zu einem Kennwert (Subskala, Skala) zusammenzufassen.

Korrelationen zwischen den (manifesten) Items werden dadurch erklärt, dass ihnen zumindest ein gemeinsames latentes Merkmal (=„Faktor“) zugrunde liegt.

Die paarweisen Korrelation zwischen den (standardisierten) Items sind selbst bei einem Faktor nicht 1, da neben dem

Einfluss des latenten Merkmals auch andere Einflüsse (wie z.B. Messfehler) berücksichtigt werden müssen.

Im Falle eines einzigen gemeinsamen latenten Merkmals, lautet die formale Darstellung der Faktorenanalyse

„itemspezifischer Faktor“ = Messfehler

Dieses Modell wird auch als das „Generalfaktormodell“ bezeichnet und geht auf Spearman zurück.

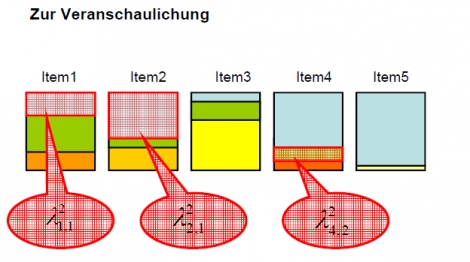

<b>

Zur Veranschaulichung</b>

Die Box steht für die Varianz des Items.

Die hellblaue Fläche für den Anteil an Varianz, der durch den ersten Faktor erklärt wird.

Die anderen Farben für die „itemspezifischen“ Einflüsse, die auf das jeweilige Item wirken. Sie sind bei jedem Item anders.

(Die Items 4 und 5 korrelieren am stärksten miteinander – da sie die größte Gemeinsamkeit haben.)

Korrelationen zwischen den (manifesten) Items werden dadurch erklärt, dass ihnen zumindest ein gemeinsames latentes Merkmal (=„Faktor“) zugrunde liegt.

Die paarweisen Korrelation zwischen den (standardisierten) Items sind selbst bei einem Faktor nicht 1, da neben dem

Einfluss des latenten Merkmals auch andere Einflüsse (wie z.B. Messfehler) berücksichtigt werden müssen.

Im Falle eines einzigen gemeinsamen latenten Merkmals, lautet die formale Darstellung der Faktorenanalyse

„itemspezifischer Faktor“ = Messfehler

Dieses Modell wird auch als das „Generalfaktormodell“ bezeichnet und geht auf Spearman zurück.

<b>

Zur Veranschaulichung</b>

Die Box steht für die Varianz des Items.

Die hellblaue Fläche für den Anteil an Varianz, der durch den ersten Faktor erklärt wird.

Die anderen Farben für die „itemspezifischen“ Einflüsse, die auf das jeweilige Item wirken. Sie sind bei jedem Item anders.

(Die Items 4 und 5 korrelieren am stärksten miteinander – da sie die größte Gemeinsamkeit haben.)

Beschreibe die Formel:

Im Falle eines einzigen gemeinsamen latenten Merkmals,

lautet die formale Darstellung der Faktorenanalyse

Zum Vergleich das Modell der einfachen Regression

lautet die formale Darstellung der Faktorenanalyse

Zum Vergleich das Modell der einfachen Regression

Tags: Faktorenanalyse, Regression

Quelle: F138

Quelle: F138

Was ist die Grundidee der Faktorenanalyse mit 2 Faktoren?

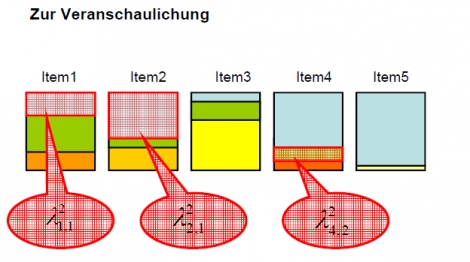

Zur Veranschaulichung

Die Box steht für die Varianz des Items.

Die hellblaue Fläche für den Anteil an Varianz, der durch den ersten Faktor erklärt wird.

Die hellgrünen Flächen für den Anteil an Varianz, der durch den

zweiten Faktor erklärt wird.

Die anderen Farben für die „itemspezifischen“ Einflüsse, die auf das jeweilige Item wirken. Sie sind bei jedem Item anders.

Tags: Faktorenanalyse

Quelle: F141

Quelle: F141

Was ist das multiple Faktorenmodell von Thurstone?

Wie lässt sich beruhend darauf die Korrelation zwischen zwei Items berechnen?

Wie lässt sich beruhend darauf die Korrelation zwischen zwei Items berechnen?

Tags: Faktorenanalyse, Korrelation

Quelle: F143

Quelle: F143

Wie hoch korrelieren folgende Items miteinander?

a) Item 1 und 3

b) Item 1 und 4

a) Item 1 und 3

b) Item 1 und 4

Multiple Faktorenanalyse - Korrelation zwischen Items

Die Berechnung kann sinnvoll sein um die Korrelation zu überprüfen wie es theoretisch ist (diese Berechnung) und realen Ergebnissen. Dies kann dabei helfen um zu überprüfen ob es möglicherweise noch einen weiteren, nicht entdeckten, Faktor gibt - wenn die theoretischen und realen Ergebnisse nicht übereinstimmen.

Um von einer Korrelation zu sprechen sollte der Unterschied nicht größer sein als 0.1

Die Berechnung kann sinnvoll sein um die Korrelation zu überprüfen wie es theoretisch ist (diese Berechnung) und realen Ergebnissen. Dies kann dabei helfen um zu überprüfen ob es möglicherweise noch einen weiteren, nicht entdeckten, Faktor gibt - wenn die theoretischen und realen Ergebnisse nicht übereinstimmen.

Um von einer Korrelation zu sprechen sollte der Unterschied nicht größer sein als 0.1

Tags: Faktorenanalyse, Korrelation

Quelle: F145

Quelle: F145

Tags: Faktorenanalyse, Kennwerte

Quelle: F146

Quelle: F146

Was versteht man unter der Ladung?

Ladungen der Faktoren pro Item

Ladung (Lambda) - Wichtig: Man liest dies von hinten (Faktor) nach vorne (Item)

-Ladung von Faktor 1 im Item 1

-Ladung von Faktor 1 im Item 2

Ladung (Lambda) - Wichtig: Man liest dies von hinten (Faktor) nach vorne (Item)

-Ladung von Faktor 1 im Item 1

-Ladung von Faktor 1 im Item 2

Tags: Faktorenanalyse, Ladung

Quelle: F147

Quelle: F147

Was versteht man unter Kommunalität eines Items?

Item 5: Die Kommunalität ist nur die hellblaue Fläche

Tags: Faktorenanalyse, Kennwert

Quelle: F150

Quelle: F150

Tags: Eigenwert, Faktorenanalyse, Kennwert

Quelle: F153

Quelle: F153

Tags: Eigenwert

Quelle: F154

Quelle: F154

Tags: Eigenwert, Kommunalität, Ladung

Quelle: F163

Quelle: F163

Berechne für folgende Werte die

- Eigenwerte?

- Prozent der Gesamtvarianz für Faktor 1 sowie Faktor 2?

- Prozent der erklärbaren Varianz für Faktor 1 und 2?

- Eigenwerte?

- Prozent der Gesamtvarianz für Faktor 1 sowie Faktor 2?

- Prozent der erklärbaren Varianz für Faktor 1 und 2?

Tags: Eigenwert, Varianz

Quelle: F164

Quelle: F164

Was ist die Grundidee der Parameterschätzung der Faktorenanalyse? Wie erfolgt die Parameterschätzung?

Die mathematische Herausforderung im Rahmen der Faktorenanalyse ist die Bestimmung der (unbekannten) Ladungen sowie die Festlegung der Faktorenzahl.

Die Grundidee der Parameterschätzung basiert darauf, zunächst jenen Faktor mit dem größten Eigenwert zu „extrahieren“. Dadurch wird die Summe der quadrierten verbleibenden Korrelationen zwischen den Items am stärksten minimiert.

Daraus folgt, dass man die Ladungen des 1. Faktors so bestimmt, dass

Die mathematische Name dieses Problems nennt sich „Eigenwert – Eigenvektor Problem“ und wurde (zum Glück) bereits gelöst.

Der Lösungsweg erfolgt iterativ und ist in realen Situationen für die händische Berechnung viel zu aufwändig.

Nach Extraktion des ersten Faktors (= Schätzung der Ladungen des ersten Faktors), wird der zweite Faktor nach derselben Grundidee extrahiert. Allerdings verwendet man hierfür nicht die originalen Korrelationen, sondern die um den Einfluss des ersten Faktors reduzierten. Diese Korrelationen werden „Restkorrelationen“ genannt.

Die Grundidee der Parameterschätzung basiert darauf, zunächst jenen Faktor mit dem größten Eigenwert zu „extrahieren“. Dadurch wird die Summe der quadrierten verbleibenden Korrelationen zwischen den Items am stärksten minimiert.

Daraus folgt, dass man die Ladungen des 1. Faktors so bestimmt, dass

Die mathematische Name dieses Problems nennt sich „Eigenwert – Eigenvektor Problem“ und wurde (zum Glück) bereits gelöst.

Der Lösungsweg erfolgt iterativ und ist in realen Situationen für die händische Berechnung viel zu aufwändig.

Nach Extraktion des ersten Faktors (= Schätzung der Ladungen des ersten Faktors), wird der zweite Faktor nach derselben Grundidee extrahiert. Allerdings verwendet man hierfür nicht die originalen Korrelationen, sondern die um den Einfluss des ersten Faktors reduzierten. Diese Korrelationen werden „Restkorrelationen“ genannt.

Tags: Faktorenanalyse, Parameterschätzung

Quelle: F165

Quelle: F165

Welche Extraktionsverfahren für die Parameterschätzung der Faktorenanalyse sind die am häufigsten angewandten?

Im Rahmen der Faktorenanalyse wurden eine Vielzahl an Extraktionsverfahren entwickelt. Die zwei am häufigsten angewandten sind

– die Hauptachsenanalyse („principal axis“) und

– die Hauptkomponentenanalyse („principal components“).

Bei der Hauptkomponentenanalyse wird davon ausgegangen, dass sich die Varianz eines Items vollständig durch die gemeinsamen Faktoren erklären lässt. Demnach sind alle Kommunalitäten (und somit auch die Korrelationen eines Items mit sich selbst) gleich 1. Als Konsequenz werden so viele Faktoren extrahiert, wie es Items gibt.

Sie ist die Standardeinstellung bei Berechnung einer Faktorenanalyse in SPSS.

Bei der Hauptachsenanalyse wird davon ausgegangen, dass sich die Varianz eines Items immer in die Kommunalität und die Einzelrestvarianz aufteilt. Demnach sind die Kommunalitäten (und somit auch die Korrelationen eines Items mit sich selbst) kleiner als 1.

Ziel ist es also, nur die durch die gemeinsamen Faktoren erklärbare Varianz zu beschreiben.

Da zu Beginn der Datenanalyse die Kommunalitäten nicht bekannt sind (=„Kommunalitätenproblem“), werden die Faktoren zunächst mittels Hauptkomponentenanalyse geschätzt und iterativ (=schrittweise) „verbessert“ („Kommunalitäteniteration“).

Kommunalitätenproblem - Vorgehensweise:

- „1“ wird in die Hauptdiagnoale geschrieben (jedes Items mit sich selbst)

- Mit der Lösung erhält man (etwas falsche) Ladungen

- Durch diese Ladungen erhält man (falsche) Kommunalitäten.

- Diese setzt man dann wiederrum in die Hauptdiagonale ein und führt die gesamte Berechnung neu durch.

- Dadurch kommt man zu immer besseren Daten.

Laut Backhaus et al.* unterscheidet sich die Interpretation der Faktoren je nach Methode.